Apple está trabajando en lo que parece ser un desarrollo técnicamente impresionante que podría mejorar la forma en que interactuamos con nuestros iPhones. La compañía planea ejecutar modelos de lenguaje avanzado (LLM), similares a ChatGPT, directamente en iPhones.

Este paso podría mejorar significativamente la funcionalidad y la inteligencia de Siri y finalmente hacer que Siri, que antes era relativamente "tonta", sea más inteligente, sin enviar datos a la nube ni generar problemas de privacidad. El equipo de investigación de Apple ha descubierto cómo debería funcionar esto técnicamente en este papel descrito.

Capítulos de esta publicación:

LLM en el iPhone: la teoría

El equipo de investigación de Apple publicó recientemente el artículo mencionado anteriormente, que describe un enfoque innovador para ejecutar modelos de lenguaje grande (LLM) en iPhones. Esta investigación muestra que es posible ejecutar algoritmos complejos de IA, que normalmente requieren servidores potentes, con los recursos comparativamente limitados de un teléfono inteligente.

Mediante el uso de técnicas de optimización especializadas y una gestión eficiente del código, Apple ha encontrado una manera de reducir la carga computacional en estos modelos para que puedan ejecutarse directamente en el iPhone sin afectar significativamente el rendimiento o la duración de la batería.

La implementación técnica

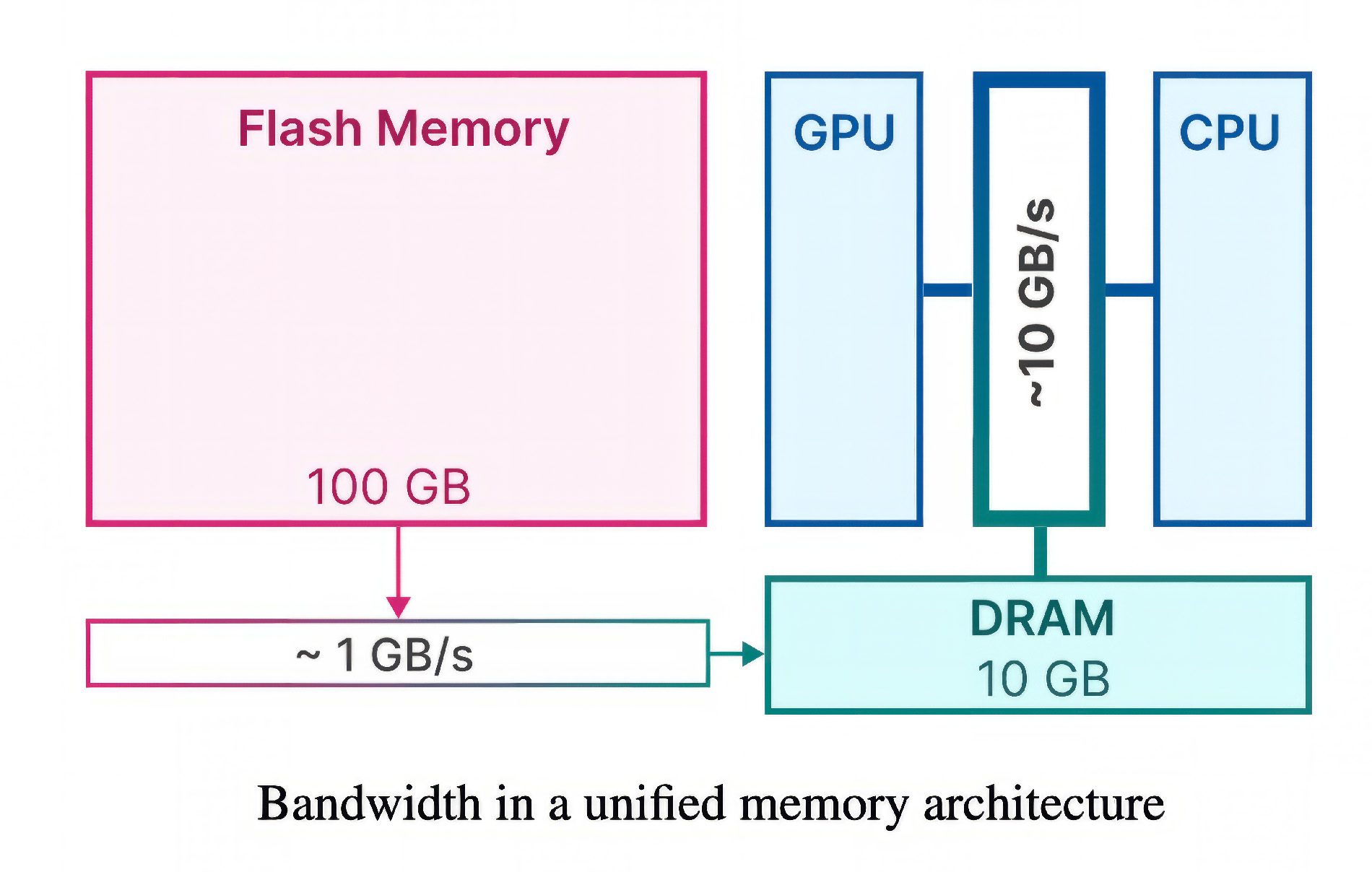

Al implementar modelos de lenguaje grande (LLM) en iPhones, Apple enfrenta un gran desafío: estos modelos requieren una gran cantidad de datos y espacio de almacenamiento, pero los iPhones tienen una memoria limitada en comparación con los servidores. Para resolver este problema, los investigadores de Apple han desarrollado una tecnología inteligente que utiliza la memoria flash del iPhone, la memoria en la que también se almacenan aplicaciones y fotos.

En lugar de depender de la memoria principal (RAM) de uso común, este método almacena los datos del modelo de IA en la memoria flash. Esto tiene dos ventajas:

- En primer lugar, el almacenamiento flash en los dispositivos móviles suele estar más disponible que la RAM.

- En segundo lugar, Apple utiliza dos técnicas especiales que minimizan la transferencia de datos y maximizan el rendimiento de la memoria flash.

Ventanas y agrupación de filas y columnas

La primera técnica se llama “Ventanas” y funciona de manera similar al reciclaje: en lugar de cargar constantemente nuevos datos, el modelo de IA reutiliza algunos de los datos que ya ha procesado. Esto reduce la necesidad de acceder constantemente a la memoria y hace que el proceso sea más rápido y fluido.

La segunda técnica, “Agrupación de filas y columnas“, es comparable a leer secciones más grandes de texto en un libro en lugar de palabras individuales. Este método agrega datos de manera más eficiente para que puedan leerse desde la memoria flash más rápidamente, lo que a su vez mejora la capacidad de la IA para comprender y generar lenguaje.

Según el artículo de investigación, estos métodos permiten ejecutar modelos de IA que equivalen a hasta el doble de la capacidad de almacenamiento disponible del iPhone. Este método podría aumentar la velocidad de 4 a 5 veces en procesadores estándar (CPU) y de 20 a 25 veces en unidades de procesamiento de gráficos (GPU). Es por eso que se trata de un avance fundamental para implementar LLM complejos en entornos con recursos limitados como el iPhone.

Impacto potencial para nosotros los usuarios

La implementación de LLM en iPhones podría tener impactos de gran alcance en la experiencia del usuario.

En primer lugar, finalmente permitiría a Siri manejar solicitudes más complejas y proporcionar respuestas contextuales más precisas. Esto podría hacer que la interacción con el iPhone sea más intuitiva y eficiente.

En segundo lugar, esta tecnología podría abrir nuevas aplicaciones en áreas como la gestión del conocimiento personal, capacidades de traducción avanzadas e incluso el desarrollo de aplicaciones interactivas basadas en la educación.

Sin embargo, por ahora estas son sólo especulaciones y posibilidades teóricas. No hay duda de que Apple planea hacer que algún tipo de ChatGPT funcione en iPhone, iPad y Mac. Sin embargo, no podemos decir mucho sobre cómo será la implementación por el momento.

Beneficios de rendimiento y protección de datos

Si bien la capacidad de ejecutar LLM en una Mac o iPhone suena bien, también presenta desafíos, particularmente cuando se trata de privacidad y seguridad. Apple es conocida por su enfoque en proteger los datos de los usuarios y enviar la menor cantidad posible de estos datos desde los propios dispositivos a los servidores de Apple.

La empresa también debe garantizar que estas nuevas funciones de IA cumplan con las estrictas directrices de protección de datos de la UE. Esto incluye el manejo de datos confidenciales, evitar la recopilación de datos no deseados y garantizar que los modelos de IA no se utilicen para fines inapropiados.

Pero el asunto también requerirá muchos recursos técnicos. La integración de IA basadas en modelos de lenguaje que luego utilizan millones de personas todos los días supondría una enorme presión para un servicio en la nube. También en este sentido, una ejecución local de la IA podría ser la mejor opción para Apple, sobre todo porque así se podrían utilizar muchas de las funciones del asistente inteligente incluso sin conexión a Internet.

Nuestra conclusión

La investigación de Apple para hacer que los LLM se ejecuten localmente en iPhone y Mac marca un hito emocionante en el desarrollo de Siri. Muestra que Apple, así como los usuarios, se han dado cuenta de que la versión actual de Siri está muy por detrás de chatbots como ChatGPT.

Aunque ahora tenemos un documento aquí que nos muestra las posibilidades técnicas para el futuro y no se han abordado características actuales en el próximo iOS, asumimos que es posible esperar algo como esto en iOS 18.

Mis consejos y trucos sobre tecnología y Apple

Contribuciones parecidas

Jens dirige el blog desde 2012. Actúa como Sir Apfelot para sus lectores y los ayuda con problemas de carácter técnico. En su tiempo libre monta monociclos eléctricos, toma fotos (preferiblemente con el iPhone, por supuesto), escala las montañas de Hesse o camina con la familia. Sus artículos tratan sobre productos de Apple, noticias del mundo de los drones o soluciones a bugs actuales.