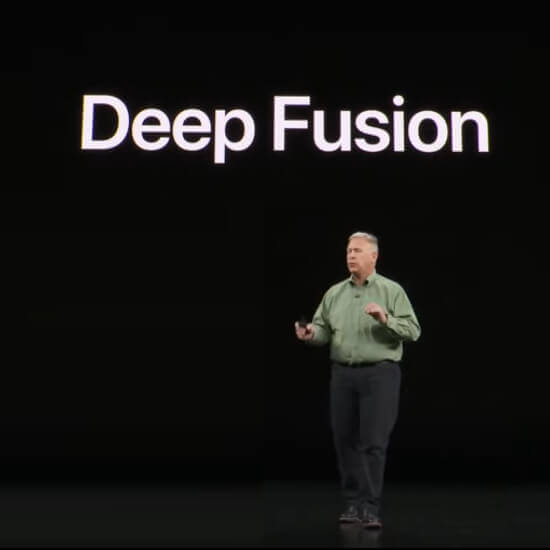

W przemówieniu, w którym między innymi zaprezentowano iPhone’a 11 Pro, Phil Schiller dał mały wgląd w funkcję, którą Apple nazywa „Deep Fusion”. Według Phila Schillera jest to fotografia wspomagana komputerowo połączona z szaloną nauką (jego cytat brzmiał: „szalona nauka fotografii obliczeniowej”). Oglądając keynote nie od razu było dla mnie jasne, co ta funkcja robi, bo dobre zdjęcia w słabym świetle były już prezentowane w keynote w związku z iPhonem 11, więc zakładam, że tu chodzi o coś więcej.

Rozdziały w tym poście:

- 1 Czym dokładnie zajmuje się Deep Fusion?

- 2 aparat iPhone 11 Pro Deep Fusion: rozdzielczość 24 MP zamiast 12 MP

- 3 alternatywa Google Night Sight od Apple

- 4 Google Night Sight vs Apple Night Mode

- 5 Kiedy Deep Fusion trafi na iPhone'a?

- 6 Moje porady i wskazówki dotyczące technologii i Apple

- 7 podobnych postów

Czym dokładnie zajmuje się Deep Fusion?

Zadałem sobie dokładnie to pytanie i ponownie spojrzałem na odpowiedni fragment w przemówieniu. Dla tych czytelników, którzy chcą oglądać dalej, zaczyna się od sygnatury czasowej 1:21:55 w keynote.

W szczegółach dzieje się tak: iPhone 11 Pro (tylko wersja z 3 obiektywami, a nie normalny iPhone 11 bez Pro!) robi dziewięć zdjęć jeszcze przed naciśnięciem spustu migawki. Cztery z nich to zdjęcia o krótkiej ekspozycji, a cztery to zdjęcia nieco dłużej naświetlone. Ostatnie zdjęcie jest zapisywane zaraz po naciśnięciu spustu migawki (zrobienie dziewięciu zdjęć), przy czym to jest długa ekspozycja.

W ciągu sekundy od naciśnięcia spustu migawki silnik neuronowy iPhone'a 11 Pro analizuje i łączy wszystkie pojedyncze ujęcia, piksel po pikselu, w jeden obraz, używając tylko najlepszych ujęć do agregacji.

Efektem końcowym jest fotografia o rozdzielczości 24 megapikseli, która charakteryzuje się szczególnie wysokim poziomem szczegółowości i niskim poziomem szumów obrazu.

Według Phila Schillera, po raz pierwszy silnik neuronowy został użyty do wydrukowania zdjęć iw tym kontekście pojawił się termin „szalona nauka fotografii obliczeniowej”.

Aparat iPhone 11 Pro Deep Fusion: rozdzielczość 24 MP zamiast 12 MP

Każdy, kto miał do czynienia z danymi technicznymi iPhone'a 11 Pro, zauważył, że trzy wbudowane aparaty mają tylko czujnik o wielkości 12 megapikseli. Tak też było w przypadku iPhone’a XS, dlatego najwyższa rozdzielczość zdjęć z iPhone’a to wcześniej 12 MP.

Jednak dzięki funkcji aparatu Deep Fusion iPhone 11 Pro wypluwa teraz zdjęcia o rozdzielczości 24 megapikseli, co można technicznie zrealizować jedynie poprzez połączenie kilku zdjęć w jedno większe, a szczegóły są tworzone przez minimalne rozmycie podczas nagrywania. Istnieje aplikacja fotograficzna o nazwie „Hydra”, która ma podobne podejście, wyrzucając zdjęcia 32 MP. Możesz pobrać próbki zdjęć tutaj na stronie programistów w sekcji „Super rozdzielczość (Zoom / Hi-Res)”.

Nawet jeśli Hydra na pewno nie jest zła, wynik osiągnięty z iPhone’em 11 Pro powinien być znacznie wygodniejszy i lepszy.

Alternatywa Google Night Sight od Apple

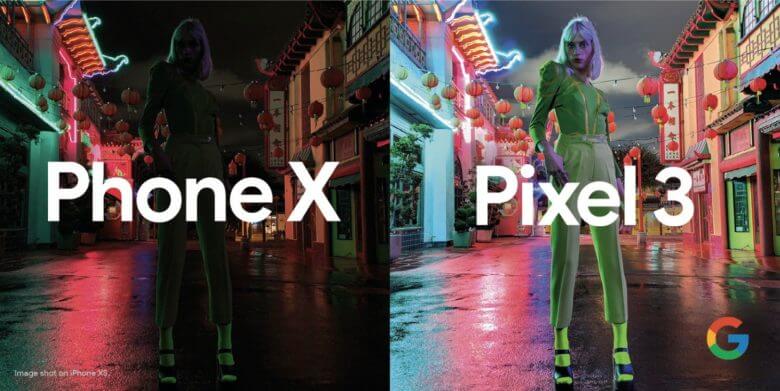

Trzeba przyznać Google, że wyraźnie przyćmili wszystkie ujęcia w słabym świetle z poprzednich iPhone'ów za pomocą zdjęć Night Sight. Zaplecze techniczne jest takie, że – o ile czytałem – smartfony Google Pixel potrafią edytować zdjęcia robione w chmurze Google i dzięki temu osiągać imponującą jakość zdjęć w trybie Night Sight. Stwierdzenie nie jest poprawne. Sprawdziłem ponownie i dowiedziałem się, że cała edycja odbywa się na Pixelu i żadne dane nie są przesyłane do chmury.

W trybie Deep Fusion iPhone'a żadne zdjęcia nie wędrują, a już na pewno nie na serwerach innych firm – chyba że wyraźnie ustawiłeś, że chcesz je znaleźć w bibliotece zdjęć iCloud. Apple jest znane z tego, że próbuje zawsze rozwiązywać takie rzeczy lokalnie na urządzeniu. Z tego powodu Deep Fusion może nadejść dopiero teraz, gdy pojawi się nowy iPhone z szybszym procesorem.

W każdym razie Apple powinien zrównać się z Google pod względem ujęć w słabym świetle dzięki tej funkcji. Pytanie tylko, czy Google ma coś w zanadrzu, by z kolejnym Pixel Phone podnieść poprzeczkę nieco wyżej.

Google Night Sight vs Apple Night Mode

Wszystkie modele iPhone'a 11 są wyposażone w funkcję o nazwie Tryb nocny, podczas gdy Deep Fusion jest prawdopodobnie zarezerwowany dla modeli Pro. Technicznie rzecz biorąc, tryb nocny jest bardziej podobny do trybu Google Night Sight, ponieważ oba tryby opierają się na dłuższych czasach naświetlania, a następnie obliczają zdjęcia razem, podobnie jak w trybie HDR. Z drugiej strony, w przypadku Deep Fusion wydaje się, że w tle dzieje się o wiele więcej „technicznej magii”.

W tym przypadku interesujące jest to, jak tryb nocny iPhone'a różni się od trybu celownika nocnego w telefonach pikselowych. Z tego, co udało mi się zebrać z poprzednich raportów z testów, tryb nocny firmy Apple wydaje się być znacznie bardziej naturalny, ponieważ zdjęcia nadal wyraźnie pokazują, że zdjęcie zostało zrobione w ciemności. Z drugiej strony w trybie Night Sight w telefonach Pixel zdjęcia wyglądają bardziej, jakby zostały zrobione w ciągu dnia.

Z punktu widzenia fotografa zdecydowanie bardziej podoba mi się podejście Apple’a, bo lubię, gdy na zdjęciach zostaje zachowany nocny nastrój, ale kolory i detale są nadal wyraźnie lepsze niż w trybie nocnym modeli iPhone’a XR, XS i XS Max

Kiedy Deep Fusion trafi na iPhone'a?

Jestem ciekaw, jak Deep Fusion sprawdza się w praktyce. Według Phila Schillera nie tylko nadaje się do fotografowania przy słabym oświetleniu, ale może również dawać imponujące rezultaty w lepszym świetle.

Jednak Deep Fusion nie jest jeszcze dostępny z dostawą modeli iPhone 11 Pro. Zostanie dodany do modeli Pro tylko przez Apple wraz z aktualizacją oprogramowania tej jesieni.

Moje wskazówki i porady dotyczące technologii i Apple

Related Stories

Jens prowadzi bloga od 2012 roku. Pełni rolę Sir Apfelot dla swoich czytelników i pomaga im w problemach natury technicznej. W wolnych chwilach jeździ na elektrycznych monocyklach, robi zdjęcia (najlepiej iPhonem oczywiście), wspina się po górach Hesji lub wędruje z rodziną. Jego artykuły dotyczą produktów Apple, nowości ze świata dronów czy rozwiązań aktualnych błędów.

„Techniczne zaplecze jest takie, że – o ile czytałem – smartfony Google Pixel potrafią edytować zdjęcia zrobione w chmurze Google i dzięki temu osiągać imponującą jakość zdjęć w trybie Night Sight”. - Co za nonsens, oznaczałoby to, że Night Sight nie działałby, gdybyś był offline. Ponadto nikt nie musi nigdzie przesyłać swojego zdjęcia. Proszę o źródło takich twierdzeń.

Witaj Mario! Masz absolutną rację. Właśnie przeczytałem o Night Sight ponownie na angielskich blogach i nigdzie nie jest napisane, że zdjęcia są przetwarzane w chmurze. Tak więc wszystko dzieje się na Google Pixel. Poprawiam fragment na górze artykułu. Dziękuję za podpowiedź. Słyszałem to oświadczenie w podcastie, ale wydawali się również źle poinformowani.