Apple arbeitet an einer technisch offenbar beeindruckenden Entwicklung, die die Art und Weise, wie wir mit unseren iPhones interagieren, zum Positiven verändern könnte. Das Unternehmen plant, fortschrittliche Sprachmodelle-Modelle (LLMs), ähnlich wie ChatGPT, direkt auf den iPhones laufen zu lassen.

Dieser Schritt könnte die Funktionalität und Intelligenz von Siri erheblich verbessern und die bisher relativ “dumme” Siri endlich schlauer machen – und das, ohne Daten in die Wolke zu schicken und Probleme mit dem Datenschutz auf den Plan zu rufen. Wie das technisch funktionieren soll, hat das Forscherteam von Apple in diesem Paper beschrieben.

Kapitel in diesem Beitrag:

LLMs auf dem iPhone – die Theorie

Apples Forschungsteam hat kürzlich das oben genannte Paper veröffentlicht, das einen innovativen Ansatz zur Ausführung von Large Language Models (LLMs) auf iPhones beschreibt. Diese Forschung zeigt, dass es möglich ist, komplexe KI-Algorithmen, die normalerweise leistungsstarke Server benötigen, auf den vergleichsweise beschränkten Ressourcen eines Smartphones zu betreiben.

Durch die Verwendung von speziellen Optimierungstechniken und effizientem Code-Management hat Apple einen Weg gefunden, die Rechenlast dieser Modelle so zu reduzieren, dass sie direkt auf dem iPhone laufen können, ohne dabei die Leistung oder die Akkulaufzeit wesentlich zu beeinträchtigen.

Die technische Umsetzung

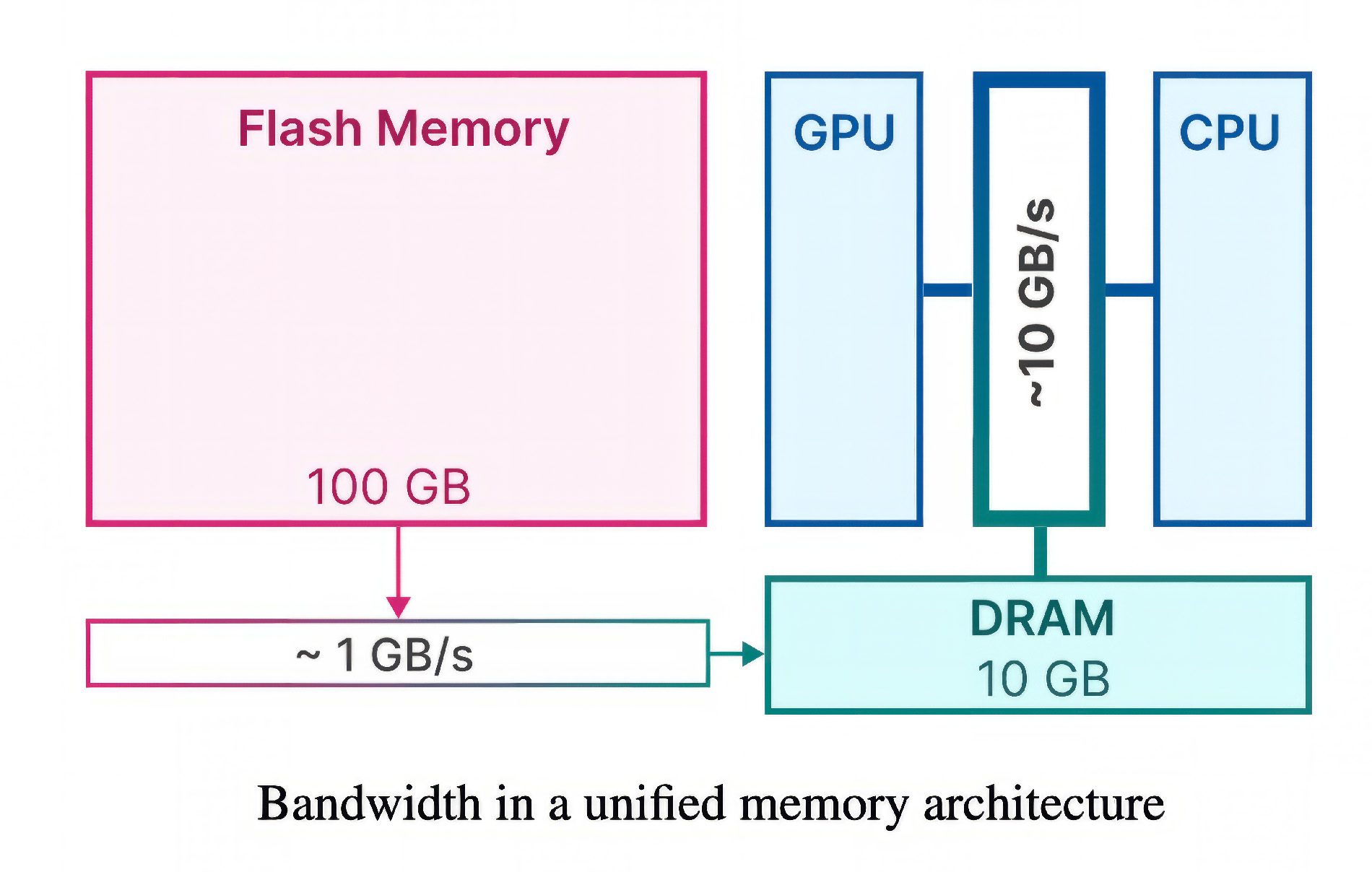

Bei der Umsetzung von Large Language Models (LLMs) auf iPhones steht Apple vor einer großen Herausforderung: Diese Modelle benötigen viel Daten und Speicherplatz, doch iPhones haben im Vergleich zu Servern begrenzten Speicher. Um dieses Problem zu lösen, haben Apples Forscher eine clevere Technik entwickelt, die den Flash-Speicher des iPhones nutzt – also den Speicher, in dem auch Apps und Fotos gespeichert sind.

Statt auf den üblicherweise genutzten Arbeitsspeicher (RAM) zu setzen, speichert diese Methode die Daten des KI-Modells im Flash-Speicher. Das hat zwei Vorteile:

- Erstens ist der Flash-Speicher in mobilen Geräten oft umfangreicher verfügbar als der RAM.

- Zweitens verwendet Apple zwei spezielle Techniken, die den Datentransfer minimieren und den Durchsatz des Flash-Speichers maximieren.

Windowing und Row-Column-Bundling

Die erste Technik nennt sich “Windowing” und funktioniert ähnlich wie Recycling: Anstatt ständig neue Daten zu laden, verwendet das KI-Modell einige der bereits verarbeiteten Daten erneut. Dies reduziert die Notwendigkeit, ständig auf den Speicher zuzugreifen, und macht den Prozess schneller und flüssiger.

Die zweite Technik, “Row-Column Bundling“, ist vergleichbar mit dem Lesen größerer Textabschnitte in einem Buch anstelle von einzelnen Wörtern. Diese Methode bündelt Daten effizienter, sodass sie schneller aus dem Flash-Speicher gelesen werden können, was wiederum die Fähigkeit der KI verbessert, Sprache zu verstehen und zu generieren.

Laut dem Forschungspapier ermöglichen diese Methoden es, KI-Modelle zu betreiben, die bis zum Doppelten der verfügbaren Speicherkapazität des iPhones entsprechen. Diese Methode könnte die Geschwindigkeit auf Standardprozessoren (CPUs) um das 4- bis 5-fache und auf Grafikprozessoren (GPUs) um das 20- bis 25-fache steigern. Darum ist dies ein entscheidender Durchbruch, um komplexe LLMs in Umgebungen mit begrenzten Ressourcen, wie auf dem iPhone, einzusetzen.

Potenzielle Auswirkungen für uns Nutzer

Die Implementierung von LLMs auf iPhones könnte weitreichende Auswirkungen auf die Nutzererfahrung haben.

Erstens würde es Siri endlich ermöglichen, komplexere Anfragen zu bearbeiten und präzisere, kontextbezogene Antworten zu liefern. Dies könnte die Interaktion mit dem iPhone intuitiver und effizienter machen.

Zweitens könnte diese Technologie neue Anwendungen in Bereichen wie persönlichem Wissensmanagement, erweiterten Übersetzungsfunktionen und sogar in der Entwicklung von interaktiven, bildungsbasierten Anwendungen eröffnen.

Allerdings sind das erstmal nur Spekulationen und theoretische Möglichkeiten. Dass Apple vorhat, eine Art ChatGPT auf dem iPhone, iPad und Mac zum Laufen zu bringen, dürfte außer Frage stellen. Wie die Umsetzung allerdings genau aussieht, darüber können wir derzeit nicht viel sagen.

Vorteile für den Datenschutz und Performance

Während die Möglichkeit, LLMs auf einem Mac oder iPhone laufen zu lassen, erst einmal gut klingt, bringt sie auch Herausforderungen mit sich, insbesondere in Bezug auf Datenschutz und Sicherheit. Apple ist ja bekannt für seinen Fokus, die Nutzerdaten zu schützen und möglichst wenige dieser Daten von den Geräten selbst an die Apple Server zu schicken.

Zudem muss das Unternehmen sicherstellen, dass diese neuen KI-Funktionen den strengen Datenschutzrichtlinien der EU entsprechen. Dies beinhaltet den Umgang mit sensiblen Daten, die Vermeidung unerwünschter Datensammlung und die Gewährleistung, dass die KI-Modelle nicht für unangemessene Zwecke genutzt werden.

Aber auch technisch dürfte die Sache viele Ressourcen benötigen. Eine Integration von KIs, die auf Sprachmodellen basieren, und die dann täglich von Millionen von Menschen verwendet werden, würde einen Clouddienst enorm beanspruchen. Auch aus dieser Hinsicht dürfte für Apple eine lokale Ausführung der KI der bessere Weg sein – zumal man dann auch ohne Internetverbindung viele Funktionen der smarten Assistentin nutzen könnte.

Unser Fazit

Die Forschung von Apple, LLMs lokal auf iPhone und Mac laufen zu lassen, markiert einen spannenden Meilenstein in der Entwicklung von Siri. Es zeigt, dass Apple – ebenso wie die Benutzer – gemerkt hat, dass die aktuelle Version von Siri im Vergleich zu Chatbots wie ChatGPT enorm hinterherhinkt.

Obwohl wir hier nun erstmal Paper haben, das uns die technischen Möglichkeiten für die Zukunft darlegt und noch keine aktuellen Features im nächsten iOS angesprochen werden, so gehen wir doch davon aus, dass eventuell schon in iOS 18 etwas in der Richtung zu erwarten ist.

Meine Tipps & Tricks rund um Technik & Apple

Ähnliche Beiträge

Seit 2012 betreibe ich meinen Blog als Sir Apfelot und helfe meinen Lesern bei technischen Problemen. In meiner Freizeit flitze ich auf elektrischen Einrädern, fotografiere mit meinem iPhone, klettere in den hessischen Bergen oder wandere mit meiner Familie. Meine Artikel behandeln Apple-Produkte, Drohnen-News und Lösungen für aktuelle Bugs.