Nach der Installation von macOS 13.1 haben mehrere Mac-Nutzer/innen berichtet, dass das System plötzlich mit einem „mediaanalysisd“-Prozess versucht, Verbindung zu einem Apple-Server aufzubauen. Vor allem beim oder nach dem Betrachten von Bildern im Finder bzw. über die QuickLook-Funktion desselben sollen Firewall-Apps wie Little Snitch den entsprechenden Netzwerk-Traffic gemeldet haben. Aufgrund der letztjährigen Diskussion rund um den CSAM-Scan (CSAM = Child Sexual Abuse Material) zum Auffinden von Material, das sexuellen Kindesmissbrauch zeigt, wurde mediaanalysisd damit in Verbindung gebracht – trotz Apples Ankündigung, das Feature nicht einzuführen. Und so entstand ein großes Missverständnis.

Kapitel in diesem Beitrag:

- 1 Gerüchte zur heimlichen Einführung des CSAM-Scans angeheizt

- 2 Was ist der mediaanalysisd Prozess überhaupt?

- 3 Wie werden Bildinhalte sicher analysiert und übermittelt?

- 4 Wurde der Bilder-Zugriff durch mediaanalysisd unter macOS 13.1 ausgeweitet?

- 5 Fazit zur Verwechslung der Bilderkennung mit dem CSAM-Scan

- 6 Meine Tipps & Tricks rund um Technik & Apple

- 7 Ähnliche Beiträge

Gerüchte zur heimlichen Einführung des CSAM-Scans angeheizt

Man möchte den Kritiker/innen des CSAM-Scans keine illegalen Handlungen vorwerfen, sondern durchaus die Motive des Datenschutzes und der Wahrung der Privatsphäre. Denn es wird von einigen nunmehr oft zitierten Leuten, gerade in der aktuellen Diskussion rund um mediaanalysisd, angenommen, dass Bilder und ihre Inhalte als bloße Kopie bei Apple landen. Und das könnte auch eigene Nacktbilder, falls vorhanden, treffen.

Jedoch gibt es eine solche Übertragung nicht. Dieses Gerücht wurde durch die Verbindung zweier Themen in die Welt gesetzt, die nichts miteinander zu tun haben. Es werden weiterhin keine Bilder an Apple übermittelt und es wird weiterhin nicht explizit nach Nacktinhalten gesucht. Das Einzige, was – wie schon seit Jahren – passiert, ist die Bildanalyse für die Objekterkennung. Und das wird klar kommuniziert.

Was ist der mediaanalysisd Prozess überhaupt?

Wie der Name schon vermuten lässt, dient mediaanalysisd der Medienanalyse, also durchaus der Einordnung von lokalen Bildinhalten. Diese kommt unter diesem Namen aber schon seit Jahren zum Einsatz, sowohl unter macOS als auch unter iOS und iPadOS. Sie dient dazu, Personen, Objekte, Tiere, Pflanzen, Kunst und dergleichen zuzuordnen, sodass man die jeweiligen Bilder in der Fotos App finden bzw. von dort heraus eine Suche in Online-Lexika anstoßen kann.

So lassen sich Pflanzen, Bäume, Hunderassen und Co. erkennen. Weiterhin fußen die Texterkennung „Live Text“ und die Erkennung von QR-Codes auf diesem Prozess. Diskussionen, vor allem zum Energieverbrauch von verbuggten Versionen, finden sich seit 2020 in Apples User-Forum und schon seit sieben Jahren in Apples Developer Forum. Es handelt sich also nicht um einen komplett neu eingeführten Systemprozess mit neuen Aufgaben.

Wie werden Bildinhalte sicher analysiert und übermittelt?

An die Apple-Server werden keine detaillierten Bildbeschreibungen mit allen kleinen und großen Details weitergereicht. Und eine Kopie der Bilder als Datei wird schon gar nicht verschickt. Es kommen Hash-Codes zum Einsatz; für den Zweck der Bilderkennung sowie der smarten Funktionen zur Verarbeitung dieser Erkennung werden sogenannte Neural Hashs verwendet.

Wie das alles funktioniert, wie die Bildanalyse im Detail abläuft und weitere Informationen findet ihr im Beitrag „Is Apple checking images we view in the Finder?“, der am 18. Januar 2023 bei The Electic Light Company veröffentlicht wurde. Da gibt es außerdem ein erklärendes Schaubild, falls der Text zu lang ist.

Wurde der Bilder-Zugriff durch mediaanalysisd unter macOS 13.1 ausgeweitet?

Nun wissen wir also, dass mediaanalysisd ein seit Jahren genutzter Prozess ist, durch den keine Bildinhalte eins zu eins übermittelt, sondern nur verschlüsselte Datenwerte versendet werden. Diese dienen der Objekterkennung sowie dem Nachschlagen von Bildinhalten, dem Identifizieren von QR-Codes sowie dem Extrahieren von Text und dem Übersetzen desselben.

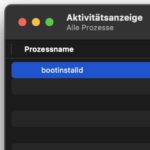

Also alles Funktionen, die seit Jahren klar kommuniziert und von vielen genutzt werden. Mit dem CSAM-Scan hat das nichts zu tun. Es wurde nur damit in Verbindung gebracht, weil dieser zuletzt ein großes, medial beachtetes Thema war. Dass der Medienanalyse-Prozess nun aber auch an Apple-Server funkt, selbst wenn die Fotos App u. ä. nicht verwendet wird, könnte schlicht ein Bug sein.

Darauf wird z. B. in diesem Twitter-Thread eingegangen. Darin wird eine technische Analyse des Prozesses aufgezeigt. Es werden Screenshots dieser Analyse geteilt, sodass man sich selber ein Bild machen kann (eine Sache, die bei den Leuten, die mediaanalysisd und CSAM-Scan in Verbindung bringen, nicht gemacht wird). So wird nachgewiesen, dass Algorithmen für die Objekterkennung zum Einsatz kommen.

Es werden zudem extrahierte Listen von möglichen Bildinhalten (Tiere) gezeigt. Weiterhin wird darauf hingewiesen, dass die Technik für die Erkennung von QR-Codes genutzt wird. Im sechsten Tweet wird die entschlüsselte Netzwerkanfrage gezeigt, die quasi leer ist. Das legt die Vermutung nahe, dass die Ausweitung von mediaanalysisd-Netzwerkanfragen unter macOS 13.1 ein Bug ist. „The network call is clearly a bug“, heißt es sogar.

Fazit zur Verwechslung der Bilderkennung mit dem CSAM-Scan

Es gibt einen Blogbeitrag, der aktuell die Runde macht und von einigen zitiert wird, die keine Recherche betreiben und lieber Anschuldigungen als Fakten teilen. Da ich dem Verfasser keine Plattform bieten will, verlinke ich diesen Blogbeitrag hier nicht. Darin geht es aber, kurz gesagt, darum, dass er weder Apple Fotos noch iCloud oder sonstige Apple-Dienste nutzt, unter macOS per Little Snitch Firewall aber den mediaanalysisd Prozess gefunden und seine eigenen Schlüsse daraus gezogen hat. Nämlich, dass Apple nun Bilder nach sexuellem Kindesmissbrauch scannt und daher Nacktbilder horten sowie Behörden eine Hintertür schaffen könnte. Diese Aussagen sind aber haltlos. Und das zeigen die oben verlinkten Quellen.

Meine Tipps & Tricks rund um Technik & Apple

Ähnliche Beiträge

Johannes hat nach dem Abitur eine Ausbildung zum Wirtschaftsassistenten in der Fachrichtung Fremdsprachen absolviert. Danach hat er sich aber für das Recherchieren und Schreiben entschieden, woraus seine Selbstständigkeit hervorging. Seit mehreren Jahren arbeitet er nun u. a. für Sir Apfelot. Seine Artikel beinhalten Produktvorstellungen, News, Anleitungen, Videospiele, Konsolen und einiges mehr. Apple Keynotes verfolgt er live per Stream.

Das ist doch exakt die selbe Funktionalität, nur zu einem anderen Zweck. NN-hashes plus Netzwerk. Das ist prinzipbedingt eine Datenschutzkatastrophe, so wie Siri. Das sind ja keine “klassischen” Hashfunktionen wie beispielsweise SHA.