Vor knapp einem Monat haben wir euch hier im Blog sowie im Podcast Apples multimodales Sprachmodell „Ferret“ vorgestellt. Dieses hat erstmals die im Geheimen durchgeführten KI-Bemühungen des iPhone-Herstellers aufgezeigt. Mit MGIE gibt es nun eine neue Apple-KI, die Bilder und Texteingaben zusammenbringt. Denn MGIE steht für „Multimodal large language model Guided Image Editing“. Hier kommt also ein multimodales Sprachmodell (MLLM) für die Bildbearbeitung zum Einsatz. So sollen Korrekturen, Filter, Effekte an einzelnen Punkten oder Objekten und so weiter durch einfache Prompts möglich werden. Mit einem Online-Tool kann man das Ganze bereits ausprobieren.

Kapitel in diesem Beitrag:

„Entferne die Wolken und gib dem Bild einen sonnigen Gelbstich“

So oder so ähnlich können die Befehle lauten, die man MGIE für die Verschönerung von Landschaftsaufnahmen geben kann. Das Verändern der Haarfarbe auf Selfies kann zudem dazu genutzt werden, das Ergebnis im Friseursalon vorauszusagen. Nach ersten Tests heißt es in der Fachpresse zu MGIE sogar, dass einige per Text übermittelte Befehle für Änderungen am eingespeisten Bild die manuelle Bearbeitung – etwa in Photoshop oder ähnlichen Programmen – ablösen könnten. Sicherlich gilt das auch für die in der Fotos App integrierten Filter und Effekte, die Apple an Mac, iPhone und iPad anbietet. Ein gelungenes Test-Beispiel findet ihr z. B. bei 9to5Mac.

Apple MGIE selber nutzen: GitHub und HuggingFace

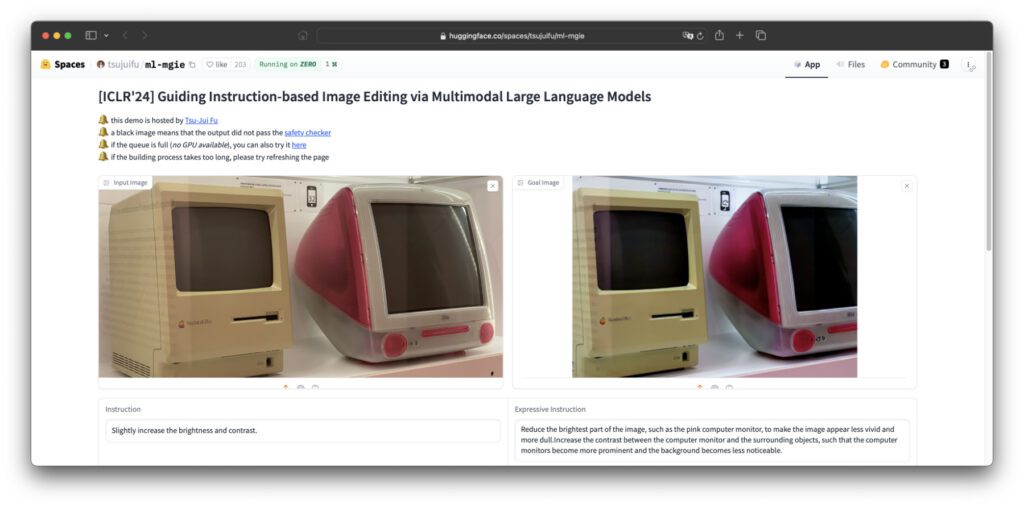

Wer mehr Hintergründe zu MGIE sucht, wird unter anderem auf GitHub fündig. Denn dort hat Apple das KI-Modell quelloffen zur Verfügung gestellt. Neben den Rohdaten gibt es zudem einige Erklärungen zur Funktionsweise und Nutzung. Wenn ihr mit den Daten nichts anfangen und keine eigene Nutzungsoberfläche basteln könnt (so wie ich), dann nutzt einfach das mit MGIE ausgestattete Web-Tool bei HuggingFace. Wie Ferret geht auch MGIE mit einem wissenschaftlichen Paper einher, das ihr euch hier herunterladen könnt. Eine Zusammenfassung mit den wichtigsten Punkten gibt es bei VentureBeat.

Für alle, die jene Infos zu MGIE lieber übersetzt haben wollen, hier das Wichtigste:

- Ausdrucksstarke textbasierte Bearbeitung: MGIE kann prägnante und klare Anweisungen erstellen, die den Bearbeitungsprozess effektiv leiten. Dadurch wird nicht nur die Qualität der Bearbeitungen verbessert, sondern auch die allgemeine Benutzerfreundlichkeit erhöht.

- Photoshop-ähnliche Modifikation: MGIE kann gängige Photoshop-ähnliche Bearbeitungen durchführen, wie z. B. Zuschneiden, Größenänderung, Drehen, Spiegeln und Hinzufügen von Filtern. Das Modell kann auch fortgeschrittenere Bearbeitungen vornehmen, z. B. den Hintergrund ändern, Objekte hinzufügen / entfernen sowie Bilder überblenden.

- Globale Fotooptimierung: MGIE kann die Gesamtqualität eines Fotos optimieren, z. B. Helligkeit, Kontrast, Schärfe und Farbbalance. Das Modell kann weiterhin künstlerische Effekte wie Skizzieren, Malen und Cartooning anwenden.

- Lokale Bearbeitung: MGIE kann bestimmte Regionen oder Objekte in einem Bild bearbeiten, z. B. Gesichter, Augen, Haare, Kleidung und Accessoires. Das Modell kann außerdem die Attribute dieser Regionen oder Objekte ändern, etwa Form, Größe, Farbe, Textur und Stil.

Wir sind gespannt auf die Neuheiten in iOS 18

Es wird vermutet, dass Apple in iOS 18 sowie damit wahrscheinlich auch in iPadOS 18 und macOS 15 verschiedene KI-Funktionen einbauen wird. Neben einer Verbesserung für die Sprachassistenz Siri scheint sich Apple nun immer mehr auf den Bereich Bilderkennung und Bildbearbeitung zu konzentrieren. Möglich ist, dass dabei nicht nur kreative Zwecke im Fokus stehen, sondern auch Bedienungshilfen. Die Erkennung der Umgebung ist ja bis zu einem gewissen Maß schon Teil der iPhone-Kamera-Funktionen – sie könnte nun aber wesentlich ausgebaut werden. Genaues wissen wir ab Juni, wenn Apple die WWDC24 abhält.

Ähnliche Beiträge

Johannes hat nach dem Abitur eine Ausbildung zum Wirtschaftsassistenten in der Fachrichtung Fremdsprachen absolviert. Danach hat er sich aber für das Recherchieren und Schreiben entschieden, woraus seine Selbstständigkeit hervorging. Seit mehreren Jahren arbeitet er nun u. a. für Sir Apfelot. Seine Artikel beinhalten Produktvorstellungen, News, Anleitungen, Videospiele, Konsolen und einiges mehr. Apple Keynotes verfolgt er live per Stream.