Für blinde Menschen und jene mit starker Einschränkung der optischen Wahrnehmung bietet Apple in der Lupe-App des iPhones einen Erkennungsmodus an. Dieser nutzt die Kamera und den LiDAR-Scanner des Geräts, um anzuzeigen, dass sich Personen oder Türen vor einem befinden. Außerdem können sich erkannte Objekte im „Beschreibungen“-Modus als Text anzeigen sowie als Sprachausgabe ansagen lassen. Neben den Ansagen zu erkannten Bildinhalten und deren Entfernung von iPhone und Nutzer/in lassen sich auch Töne und haptisches Feedback einstellen. In diesem Ratgeber erfahrt ihr, wie ihr das Ganze einrichtet und welche Schwächen die Technik hat.

Kapitel in diesem Beitrag:

iPhone Erkennungsmodus in der Lupe-App aktivieren: So geht’s!

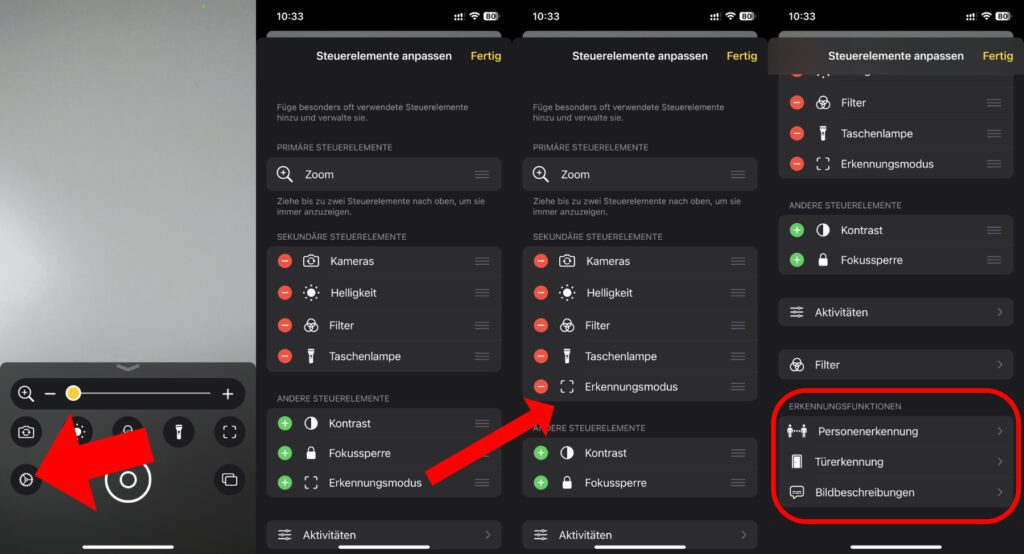

Um die Umgebung vom iPhone erkennen zu lassen und entsprechende Ausgaben für die eigene Interpretation zu erhalten, muss zuerst der Erkennungsmodus zu den sekundären Steuerelementen der Lupe-App hinzugefügt werden. Das klingt schwierig, heißt aber im Grunde nur, dass das Symbol für die Umwelterkennung zur grafischen Oberfläche der App hinzugefügt wird. Und so geht ihr dafür vor:

- Öffnet die Lupe-App auf dem Apple iPhone

- Tippt das Zahnrad-Symbol unten links an, um die Einstellungen zu öffnen

- Bewegt den Erkennungsmodus von „Andere Steuerelemente“ zu „Sekundäre Steuerelemente“ – entweder über das Plus-Symbol oder durch verschieben

- Scrollt nach unten, um weitere Einstellungen vorzunehmen

- Passt unter „Erkennungsfunktionen“ die Einstellungen für Personenerkennung, Türerkennung und Bildbeschreibung an, indem ihr die einzelnen Punkte antippt und ihre Menüs nutzt

Die Feineinstellungen für den iPhone Lupe-Erkennungsmodus

Wie schon aufgezeigt, so gibt es drei verschiedene Möglichkeiten, mit denen man sich die Erkennungsfunktion der iPhone-Kamera zunutze machen kann: Personenerkennung, Türerkennung und Bildbeschreibung. Für alle drei schneide ich im Folgenden die Feineinstellungen an, damit ihr einen Überblick erhaltet. Die genauen Einstellungen hängen natürlich davon ab, wie ihr die Technik nutzen wollt. Vielleicht müsst ihr auch erst einmal ein paar Sachen ausprobieren, bis ihr die ideale Kombination der einzelnen Möglichkeiten findet.

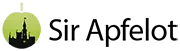

Personenerkennung

Unter Lupe, Einstellungen, Personenerkennung könnt ihr einstellen, ab welcher Entfernung der abgespielte Ton höher wird bzw. sich das haptische Feedback in schnellerer Frequenz meldet. Standardmäßig ist die Entfernungseinheit Meter eingestellt, und zwei Meter Entfernung für den Start der höheren Töne. Beides lässt sich aber anpassen; die zweite Maßeinheit, die genutzt werden kann, ist Fuß.

Zudem können neben den Tönen, welche standardmäßig aktiviert sind, auch eine Sprachausgabe und die schon erwähnte Haptik aktiviert werden, um die Erkennung von Personen anzuzeigen. Für die Sprachausgabe muss der Klingelmodus des iPhones aktiviert sein (Schieberegler an der linken Seite des Geräts in Richtung Display schieben).

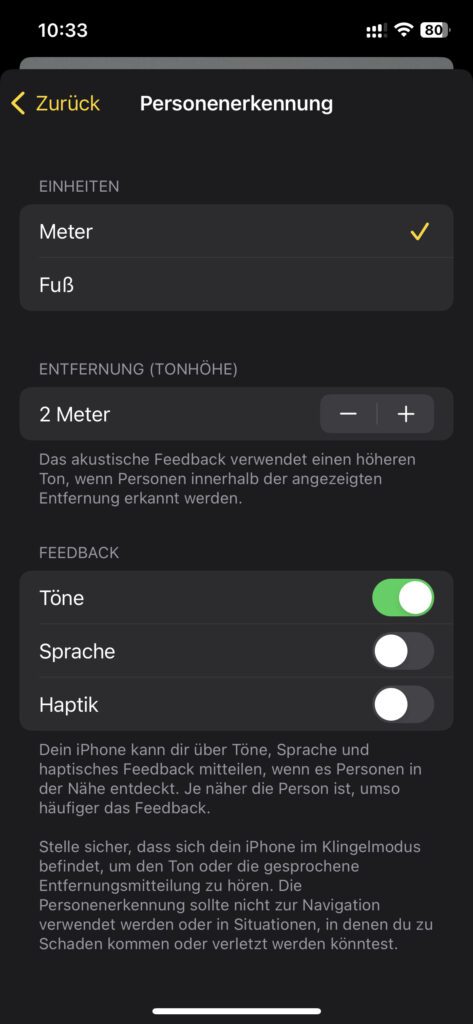

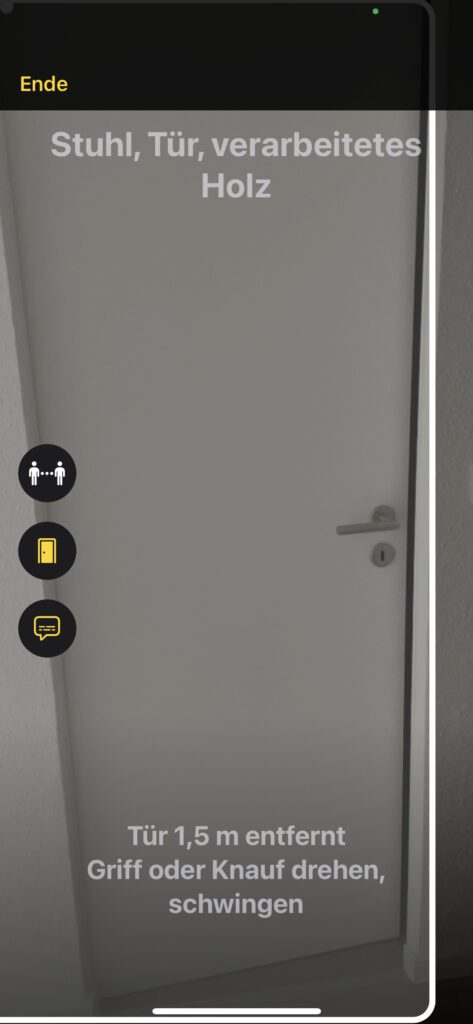

Türerkennung

Bei der Türerkennung gibt es ebenfalls die drei Ausgabemöglichkeiten Töne, Sprache und Haptik. Diese können übrigens individuell kombiniert, also auch alle drei gleichzeitig aktiviert werden. Zudem ist hier ebenfalls möglich, die Entfernung für höhere Töne, schnelleres haptisches Feedback bzw. häufigere Sprachausgaben einzustellen – wahlweise in Meter oder Fuß. Für die Sprachausgabe muss der Klingelmodus des iPhones aktiv sein, wie auch bei der Personenerkennung. Allerdings gibt es, wenn ihr im Türerkennung-Menü nach unten scrollt, noch mehr Einstellungen.

So lässt sich zum Markieren von entdeckten Türen auf dem iPhone-Display eine Farbe auswählen. Das ist praktisch, um einen höchstmöglichen Kontrast zu erwirken und den optischen Hinweis auch mit starker Sehschwäche wahrzunehmen. Außerdem kann das doppelte Tippen auf die Rückseite des iPhones weitere Details zu den Türen entlocken (Option standardmäßig deaktiviert). Auch Türattribute und Türbeschilderungen lassen sich ausgeben. Beides ist standardmäßig aktiviert. So können etwa Namen von Läden und Restaurants bzw. deren Öffnungszeiten angesagt werden.

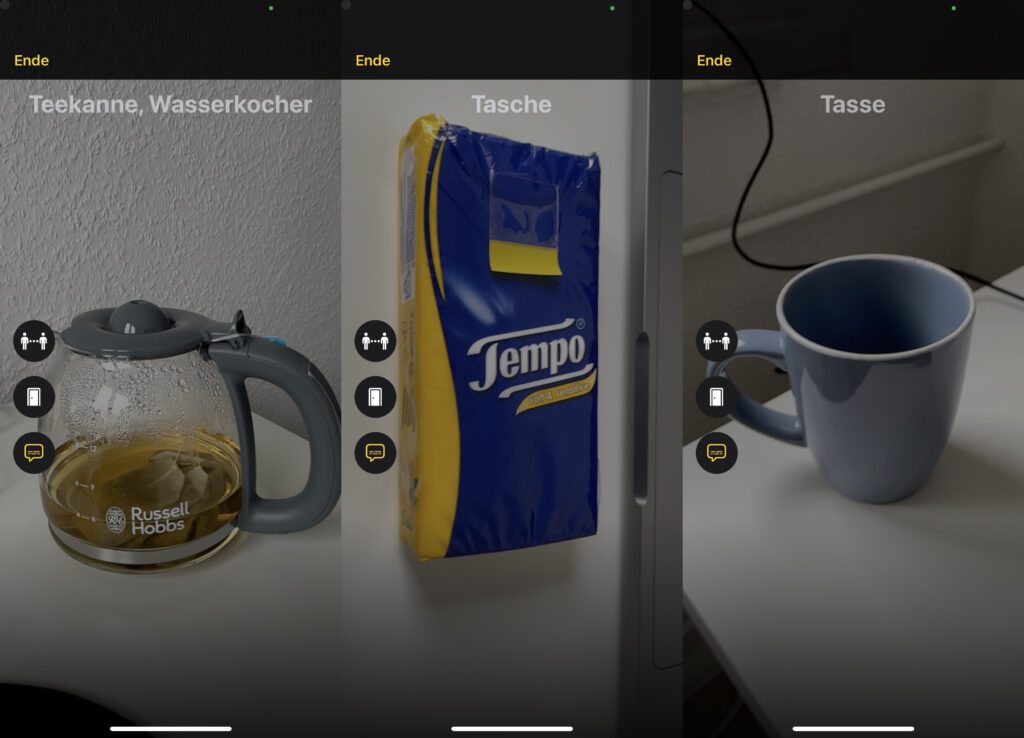

Bildbeschreibung

Die Optionen für die Bildbeschreibung im Erkennungsmodus der iPhone-Lupe sind weniger umfangreich. Hier lässt sich lediglich einstellen, ob man eine Textausgabe auf dem Display oder eine Sprachausgabe über die Lautsprecher bzw. Kopfhörer haben möchte – oder beides.

Der Erkennungsmodus ist gut, könnte aber besser sein

Ich habe den Erkennungsmodus für diesen Beitrag kurz am iPhone 12 Pro unter iOS 16.1.2 ausprobiert. Dabei habe ich hauptsächlich die Türerkennung und die Bildbeschreibung getestet. Durch den LiDAR-Scanner waren die angezeigten sowie durch Töne, Haptik und Ansagen gemeldeten Entfernungen immer korrekt. Man kann sich hier wohl mit hoher Wahrscheinlichkeit darauf verlassen, dass man gut durch die Umwelt geführt wird bzw. mehr Input für die eigene Orientierung erhält. Laut Apple sollte man sich aber nicht in Situationen, in denen man verletzt werden könnte, bzw. in Notsituationen darauf verlassen.

Bei der Unterscheidung von Fenstern und Türen hat die Technik auch gut abgeschnitten. Getestet habe ich das u. a. bei normalen Zimmertüren und Fenstern sowie bei einer Balkontür und daneben angebrachten Fenstern. Da wurde nichts durcheinander gebracht. Allerdings wurde die Balkontür bei mehrmaligem Testen mal als einfache Tür, mal als Aufzugtür, mal als andere Tür erkannt und auch verschiedene Öffnungshinweise gegeben. Hier muss Apple noch an der Genauigkeit arbeiten.

Die Bildbeschreibung als Umgebungserkennung wirkte in meinem kurzen Test noch ein bisschen experimentell. Eine Teekanne wurde erst als Glühbirne, dann als Trophäe, dann als Kopfhörer und erst zuletzt als Teekanne bzw. Kochgeschirr erkannt. Dazu musste ich aber alle anderen Objekte aus dem Bild räumen und die Kanne vor eine weiße Wand stellen. Eine Taschentuchpackung wurde erst als Kreditkarte, dann als Snack, dann als Tasche erkannt. Jedoch: bei einem Laptop, einer Tasse, einem Fenster und anderen eher eindeutigen Sachen gab es kein Rätselraten, sondern direkt das richtige Ergebnis.

Ähnliche Beiträge

Johannes hat nach dem Abitur eine Ausbildung zum Wirtschaftsassistenten in der Fachrichtung Fremdsprachen absolviert. Danach hat er sich aber für das Recherchieren und Schreiben entschieden, woraus seine Selbstständigkeit hervorging. Seit mehreren Jahren arbeitet er nun u. a. für Sir Apfelot. Seine Artikel beinhalten Produktvorstellungen, News, Anleitungen, Videospiele, Konsolen und einiges mehr. Apple Keynotes verfolgt er live per Stream.